Blokowanie dostępu robotom wyszukiwarek do strony

Przechowujesz na stronie informacje, do których dostęp mają tylko zarejestrowani użytkownicy? Nie pozwól, żeby roboty wyszukiwarek zapisywały te dane.

1. Plik robots.txt

Ten plik tekstowy jest sprawdzany przez roboty wyszukiwarek. Można go wykorzystać do zablokowania określonych lokalizacji na serwerze, wykorzystując specjalny protokół Robots Exclusion Protocol.

Plik "robots.txt" umieszcza się w katalogu głównym strony, aby zablokować wszystkie roboty wyszukiwarek (gwiazdka * określa wszystkie roboty). Należy skorzystać z poniższego kodu:

User-agent: *

Disallow: /

- user-agent - określa które roboty mają przestrzegać podane warunki,

- disallow - określa lokalizację która jest blokowana,

Podanym sposobem zablokujemy wszystkie katalogi wraz z plikami, które znajdują się na serwerze w katalogu głównym strony ("Disallow: /").

Jeżeli chcemy zablokować np. robotowi wyszukiwarki Google, tylko określone katalogi wraz z ich zawartością, należy:

User-agent: googlebot

Disallow: /dokumenty/

Disallow: /kopie-robocze/dokument.html

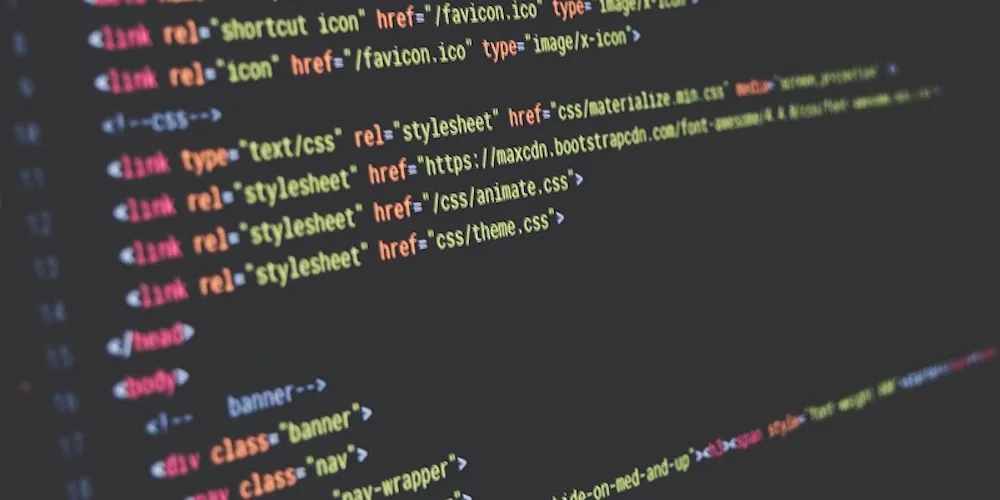

2. Deklaracja znacznika META

Taką deklarację należy umieścić w ramach HEAD, w dokumencie HTML.

<meta name="Robots" content="index, follow">

- index - indeksowanie wszystkiego,

- noindex - brak indeksacji,

- follow - indeksowanie stron, do których można dotrzeć przez linki,

- nofollow - brak indeksacji stron, do których linki znajdują się na danej witrynie,

- none - odpowiednik noindex, nofollow,

- all - odpowiednik index, follow,

Kategorie: HTML + CSS. Tagi: #google, #html, #wyszukiwarki internetowe. Źródło obrazków: Pixabay, Font awesome.